在大数据时代,海量数据的处理成为一项重要的任务。然而,数据中常常存在着大量重复的信息,这些重复数据不仅浪费存储空间,还会干扰分析结果的准确性。本文将介绍一些有效的技巧和方法,帮助你高效筛选重复数据,提升数据处理的效率。

段落

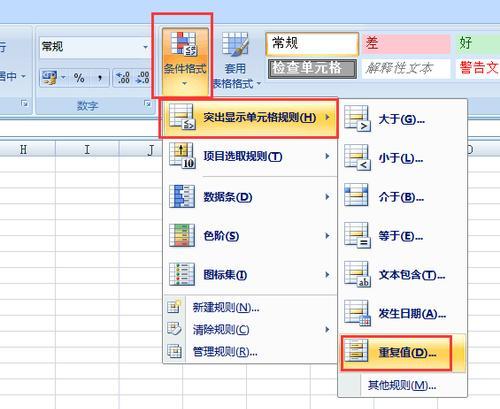

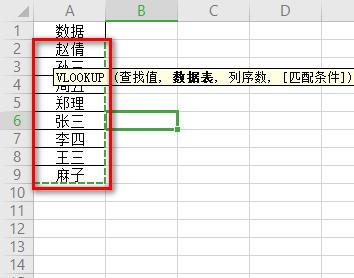

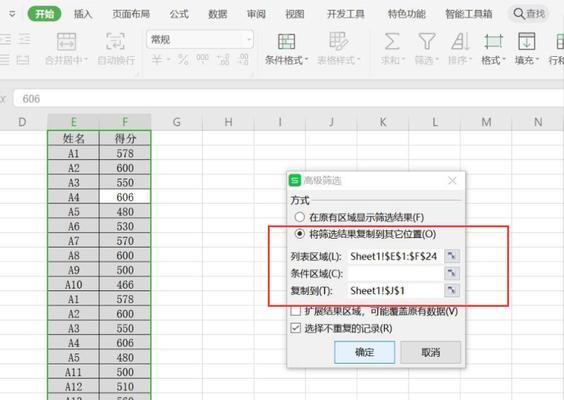

1.使用Excel的条件格式功能

使用Excel的条件格式功能可以快速标记出重复数据,在数据量较小且操作简单的情况下尤为实用。具体操作方法是在Excel中选中需要进行重复数据筛选的列,然后点击“条件格式”->“突出显示规则”->“重复项”,即可将重复数据标记出来。

2.利用数据库的去重功能

对于较大的数据集,使用数据库的去重功能是一个高效的方法。通过SQL语句中的DISTINCT关键字,可以轻松地去除重复数据。SELECTDISTINCTcolumn_nameFROMtable_name;将返回该列中唯一的值。

3.使用Python编程语言进行重复数据筛选

对于需要进行大规模数据处理的情况,使用Python编程语言能够更高效地筛选重复数据。可以利用Python中的pandas库,使用drop_duplicates()函数实现去重功能。具体操作是将数据导入pandas的DataFrame对象中,然后调用drop_duplicates()函数。

4.采用哈希算法进行重复数据筛选

哈希算法是一种常用的快速查找和去重的技术。它将数据映射为唯一的哈希值,通过比较哈希值来判断是否为重复数据。可以利用哈希表或者布隆过滤器等数据结构来实现重复数据的筛选。

5.使用数据清洗工具进行去重处理

现在市面上有许多专门的数据清洗工具,可以帮助用户高效地去除重复数据。这些工具通常提供直观友好的操作界面和强大的去重功能,能够满足不同规模数据处理的需求。

6.结合人工审核进行重复数据筛选

在某些情况下,自动化的重复数据筛选可能会存在一定的误差。为了提高准确性,可以结合人工审核的方式进行筛选。通过人工审核,可以进一步确认哪些数据是真正的重复数据,避免误删。

7.选择合适的去重策略

不同的数据场景可能需要采用不同的去重策略。有时,我们只需要去除某一列中的重复数据,而保留其他列的信息;有时,我们需要全面去除所有重复数据。在筛选重复数据之前,需明确去重的目标和策略。

8.注意处理特殊情况下的重复数据

在实际应用中,有些情况下重复数据不是错误的,而是需要保留的重要信息。在用户行为分析中,同一用户在不同时间段的多次访问记录可能被视为重复数据,但对于分析用户行为的连续性非常有用。

9.借助第三方工具进行数据清洗

除了上述提到的数据清洗工具,还可以借助一些第三方工具进行数据清洗和去重。这些工具通常提供了更加强大的功能和更高的性能,适用于更复杂的数据处理场景。

10.制定标准化的数据录入规范

重复数据往往源于数据录入过程中的错误或疏漏。为了减少重复数据的产生,在数据录入过程中,制定标准化的数据录入规范是十分必要的。对于姓名字段,规定只录入全名而不是姓和名分开录入。

11.定期进行数据维护和清理

数据随着时间的推移,可能会产生更多的重复数据。定期进行数据维护和清理是保持数据质量的重要手段。可以设置定期任务,对数据进行清理和去重处理。

12.保留原始数据备份

在进行重复数据筛选和清理之前,务必保留原始数据的备份。这样,即使在处理过程中出现错误或误删,也能够及时恢复原始数据,避免数据丢失。

13.检查筛选结果的准确性

筛选完重复数据后,应该对筛选结果进行检查,确保准确无误。可以随机选择一些样本数据进行比对,或者使用其他方式验证筛选结果。

14.常见的重复数据产生原因

重复数据产生的原因有很多,例如数据导入时的重复录入、系统故障造成的重复数据、数据源本身存在的问题等。常见的重复数据产生原因,有助于从根本上减少重复数据的产生。

15.不断学习和改进筛选方法

数据处理和筛选技术日新月异,不断学习和改进筛选方法是保持竞争力的关键。关注最新的数据处理技术和工具,不断优化重复数据筛选的方法和流程。

筛选重复数据是大数据处理中一个关键的步骤,本文介绍了多种有效的筛选方法和技巧。无论是使用Excel的条件格式功能,还是借助数据库、编程语言或第三方工具,都可以帮助你提高数据处理的效率,减少重复数据带来的问题。选择适合自己的筛选方法,并注意数据处理过程中的准确性和可靠性,将为你的数据分析和决策提供有力的支持。