在当今互联网信息爆炸的时代,数据采集已成为一个不可或缺的环节。服务器采集,特别是针对特定类型如T1服务器的采集,对于数据处理、存储和分析具有重要的实际应用价值。但很多人在进行采集工作时可能会遇到各种问题。本篇文章将为您深入解析T1服务器的采集方法,并对采集过程中可能会出现的问题进行详细说明。

一、T1服务器采集的准备工作

在采集之前,我们首先需要了解什么是T1服务器。T1服务器通常是指具备稳定运行能力、高可用性、良好的扩展性和高效处理能力的服务器。这类服务器往往适用于大型企业的核心数据处理任务。

1.采集工具的选择

采集工作离不开合适的工具,选择适合T1服务器特点的采集工具是成功的第一步。建议选择一些高效且稳定的专业数据采集软件,比如Octoparse、WebHarvy等,这些工具支持自定义数据采集规则,能够满足T1服务器的高级需求。

2.目标网站的分析

在开始采集前,对目标网站结构进行详细分析是至关重要的。这包括了解网站的URL结构、页面布局、数据存储方式等信息。这一步将为后续的采集规则设定提供基础。

3.法律法规的遵守

数据采集绝不能忽略相关的法律法规。在采集之前,务必确认采集的内容是否涉及隐私保护、版权问题等法律风险,并确保采集活动合法合规。

二、T1服务器的采集方法

1.规则定制与测试

根据目标网站的分析结果定制采集规则,然后进行小规模的测试,确认规则的准确性。如果规则设定正确,再逐步扩大采集范围。

2.监控与维护

采集过程中,实时监控采集任务的状态,及时调整采集策略,以适应网站的更新和变化。同时,保持服务器的稳定运行,定期进行维护。

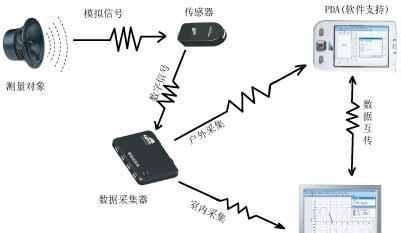

3.数据提取与存储

成功采集的数据需要进行提取和清洗,以确保数据质量。提取后的数据应存储在T1服务器的可靠存储系统中,例如高性能的SSD硬盘或者可靠的RAID阵列。

三、采集过程中常见的问题及应对策略

1.数据采集速度慢

问题分析:可能由于采集频率过高,目标网站的反爬虫机制触发,或者服务器性能不足导致采集速度慢。

解决策略:优化采集频率,合理设置延迟时间,并且升级服务器硬件,比如使用更高性能的CPU和更多的内存。

2.采集的数据不准确

问题分析:规则设置错误或者目标网站结构发生变化。

解决策略:定期检查和更新采集规则,确保规则与目标网站结构保持一致。

3.法律风险

问题分析:采集过程中可能不小心触犯相关法律法规,如未经许可采集受版权保护的数据。

解决策略:在采集前,仔细研究并遵守相关法律法规,必要时获取数据所有者的许可。

4.网站反爬虫机制

问题分析:网站可能有反爬虫机制,如IP封禁、验证码等。

解决策略:使用代理IP池,设置合理的请求头(User-Agent、Cookies等),并编写验证码识别脚本,或采用人工验证等手段应对。

四、数据采集后的处理

采集到的数据通常需要经过处理,比如清洗、格式转换、去重等。这一步骤对于数据后续的分析和应用至关重要。

1.数据清洗

清洗不完整、错误或格式不统一的数据,确保数据的可用性。

2.格式转换

将数据转换为适合分析和使用的格式,如CSV、JSON等。

3.数据去重

去除重复数据,保证数据质量。

五、

采集T1服务器上的数据是一个系统而复杂的过程,需要充分的准备、正确的工具选择、合理的规则设定、及时的监控调整、严格的数据处理等。掌握正确的采集方法并妥善处理常见问题,可以显著提高数据采集的效率和质量。务必记得,合法合规采集是前提,技术和策略的不断优化是保障,只有这样,才能在大数据时代中掌握主动权,实现数据的价值最大化。